- علمت CNBC أن نموذج لغة PaLM 2 الضخم من Google يستخدم ما يقرب من خمسة أضعاف البيانات النصية للتدريب مقارنة بسابقه LLM.

- أعلنت شركة Google ، التي أعلنت عن PaLM 2 الأسبوع الماضي ، أن النموذج أصغر من طراز PaLM السابق ولكنه يستخدم “تقنية” أكثر كفاءة.

- أصبح الافتقار إلى الشفافية حول بيانات التدريب في نماذج الذكاء الاصطناعي موضوعًا ساخنًا بشكل متزايد بين الباحثين.

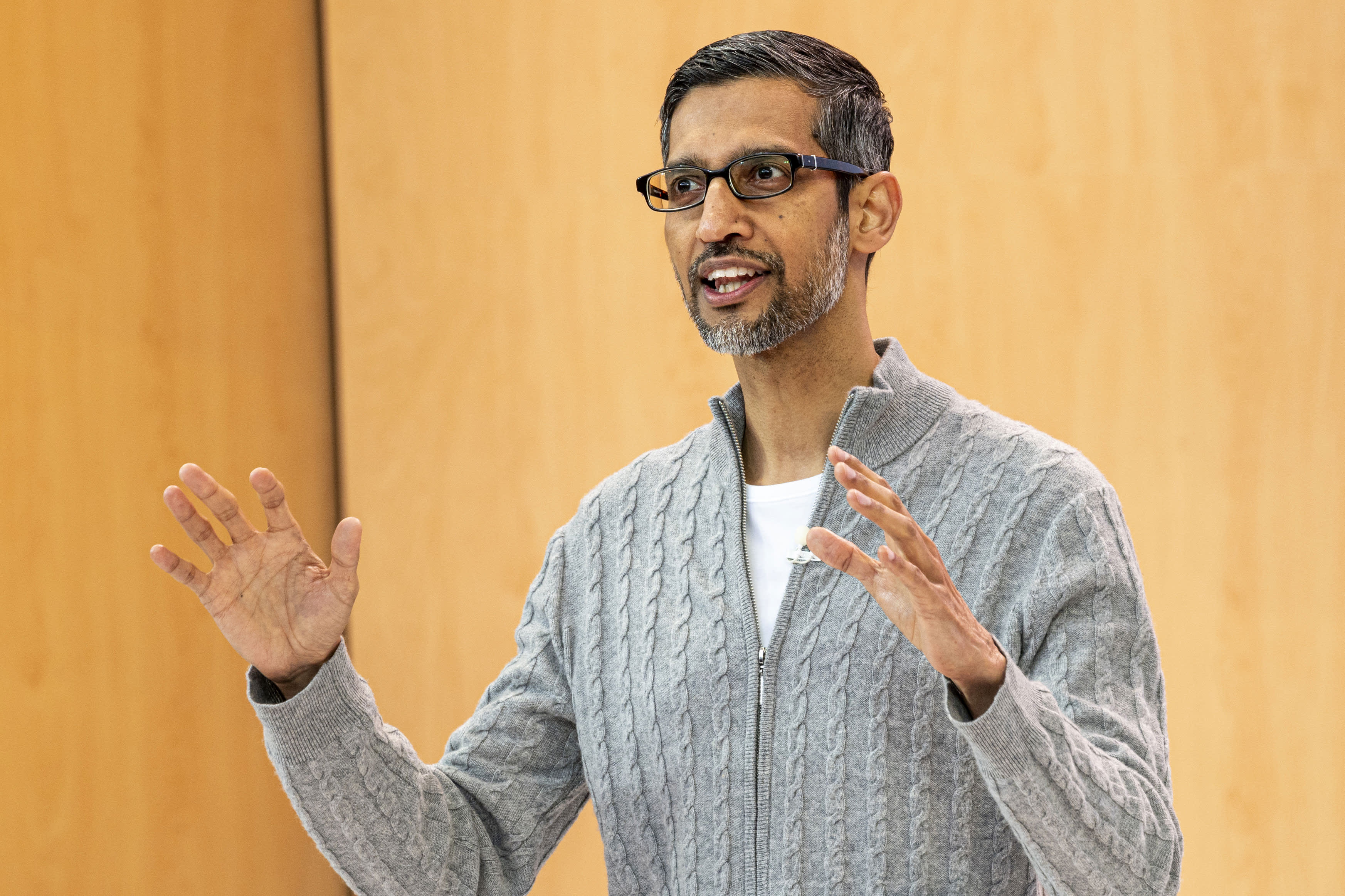

سوندار بيتشاي ، الرئيس التنفيذي لشركة Alphabet Inc. ، في مؤتمر Google I / O Developers في ماونتن فيو ، كاليفورنيا ، الأربعاء ، 10 مايو ، 2023.

ديفيد بول موريس | بلومبرج | صور جيتي

يستخدم نموذج اللغة الكبيرة الجديد من Google ، الذي أعلنت عنه الشركة الأسبوع الماضي ، ما يقرب من خمسة أضعاف بيانات التدريب عن سابقتها في عام 2022 ، مما يسمح لها بأداء مهام الترميز والرياضيات والتعلم. علمت CNBC أن الكتابة الإبداعية الأكثر تقدمًا.

تم تدريب PaLM 2 ، نموذج الشركة الجديد للغة العامة للأغراض العامة (LLM) الذي تم الكشف عنه في Google I / O ، على 3.6 تريليون رمز ، وفقًا للوثائق الداخلية التي شاهدتها CNBC. الرموز ، وهي سلاسل من الكلمات ، هي لبنة بناء مهمة لتدريب LLM لأنها تعلم النموذج للتنبؤ بالكلمة التالية التي ستظهر في تسلسل.

تم إصدار إصدار Google السابق من PaLM ، والذي يمثل نموذج لغة Pathways ، في عام 2022 وتم تدريبه على 780 مليار رمز مميز.

بينما كانت Google حريصة على إظهار قوة تقنية الذكاء الاصطناعي الخاصة بها وكيف يمكن دمجها في البحث والبريد الإلكتروني ومعالجة النصوص وجداول البيانات ، لم ترغب الشركة في نشر الحجم أو التفاصيل الأخرى لبيانات التدريب الخاصة بها. حافظت شركة OpenAI ، التي ابتكرت ChatGPT المدعومة من Microsoft ، أيضًا على سرية تفاصيل أحدث إصدار من LLM يسمى GPT-4.

سبب عدم الإفصاح ، حسب الشركات ، هو الطبيعة التنافسية للأعمال. تتسابق Google و OpenAI لجذب المستخدمين الذين يرغبون في البحث عن المعلومات باستخدام روبوتات المحادثة بدلاً من محركات البحث التقليدية.

ولكن مع اشتداد سباق التسلح في مجال الذكاء الاصطناعي ، يطالب مجتمع البحث بمزيد من الشفافية.

منذ الكشف عن PaLM 2 ، قالت Google إن النموذج الجديد أصغر من LLMs السابقة ، وهو أمر مهم لأنه يعني أن تقنية الشركة تصبح أكثر كفاءة أثناء أداء مهام أكثر تعقيدًا. يتم تدريب PaLM 2 ، وفقًا للوثائق الداخلية ، على 340 مليار معلمة ، وهو مؤشر على مدى تعقيد النموذج. تم تدريب PaLM الأولي على 540 مليار معلمة.

لم تقدم Google تعليقًا على الفور على هذه القصة.

جوجل قال في منشور مدونة على PaLM 2 ، يستخدم النموذج “تقنية جديدة” تسمى “التحجيم الأمثل للحساب”. هذا يجعل LLM “أكثر كفاءة مع أداء عام أفضل ، بما في ذلك استدلال أسرع ، ومعلمات أقل للخدمة ، وتكلفة خدمة أقل.”

عند الإعلان عن PaLM 2 ، أكدت Google تقارير CNBC السابقة بأن النموذج مدرب بـ 100 لغة ويؤدي مجموعة واسعة من المهام. يتم استخدامه بالفعل لتشغيل 25 ميزة ومنتجات ، بما في ذلك chatbot التجريبي للشركة ، Bard. إنه متوفر بأربعة أحجام ، من الأصغر إلى الأكبر: Gecko و Otter و Bison و Unicorn.

يعتبر PaLM 2 أقوى من أي نموذج قائم قائم على الإفصاحات العامة. LLM على Facebook يسمى LLaMA ، وهو إعلان في فبراير ، يتكون من 1.4 تريليون توكن. كانت آخر مرة شاركت فيها OpenAI حجم تدريب ChatGPT مع GPT-3 ، عندما قالت الشركة إنها تدربت على 300 مليار رمز في ذلك الوقت. أصدرت شركة OpenAI GPT-4 في مارس وقالت إنها أظهرت “أداءً على مستوى الإنسان” في العديد من الاختبارات المهنية.

LaMDA ، محادثة LLM أن Google قدَّم قبل عامين وتم الترويج له في فبراير جنبًا إلى جنب مع Bard ، تم تشكيله على 1.5 تريليون رمز ، وفقًا لأحدث الوثائق التي اطلعت عليها CNBC.

نظرًا لأن تطبيقات الذكاء الاصطناعي الجديدة أصبحت سائدة بسرعة ، فإن الجدل الدائر حول التكنولوجيا الأساسية أصبح أكثر سخونة.

المهدي المحمدي ، كبير العلماء في Google Research ، استقال في فبراير على افتقار الشركة للشفافية. يوم الثلاثاء ، أدلى الرئيس التنفيذي لشركة OpenAI ، سام ألتمان ، بشهادته في جلسة استماع للجنة الفرعية القضائية التابعة لمجلس الشيوخ بشأن الخصوصية والتكنولوجيا ، واتفق مع المشرعين على أن هناك حاجة إلى نظام جديد للتعامل مع الذكاء الاصطناعي.

قال ألتمان: “بالنسبة للتكنولوجيا الجديدة ، نحتاج إلى إطار عمل جديد”. “بالتأكيد تتحمل شركات مثل شركتنا مسؤولية كبيرة عن الأدوات التي نطرحها في العالم.”

– ساهم جوردان نوفيت من سي إن بي سي في هذا التقرير.

ساعة: دعا سام ألتمان ، الرئيس التنفيذي لشركة OpenAI ، إلى الإشراف على الذكاء الاصطناعي

Social media junkie. Zombie fanatic. Travel fanatic. Music obsessed. Bacon expert.